Amazon ermöglicht es Unternehmen, ihre eigenen generativen KI-Modelle auf seiner Entwicklungsplattform für KI einzusetzen. Dieser Schritt ist Teil einer Reihe von Maßnahmen, die der Cloud-Computing-Riese einführt, um mit Konkurrenten im KI-Bereich Schritt zu halten.

Die Cloud-Computing-Abteilung des Unternehmens hat nicht ganz den Aufruhr verursacht, den seine auf KI fokussierten Konkurrenten erlebt haben, sondern setzt darauf, dass Unternehmen ihre KI-Modelle nutzen möchten.

AWS’s Grundstein

Während Unternehmen mit generativer KI für verschiedene Aufgaben experimentieren und diese einsetzen, entwickeln viele ihre KI, indem sie ein Modell eines Anbieters anpassen oder Open-Source-Modelle basierend auf ihren eigenen Daten modifizieren.

Amazon Web Services gab bekannt, dass „Zehntausende“ von Unternehmen Bedrock nutzen, seine Plattform zur Entwicklung von KI-Anwendungen. Unternehmen die Möglichkeit zu geben, „Do-it-yourself“-Modelle zu Bedrock hinzuzufügen, erleichtert die Zusammenarbeit zwischen Unternehmensentwicklern und Datenspezialisten, so Swami Sivasubramanian, der Vizepräsident von AWS für KI und Daten.

Insgesamt hinkt Amazon im KI-Rennen seinen technologischen Rivalen hinterher, versucht jedoch, seine Position durch neue Angebote auf AWS und in seinem Einzelhandelsgeschäft zu stärken. AWS fehlt eine prägende KI-Partnerschaft wie Microsofts mit OpenAI oder Copilot, Microsofts KI-gestütztem generativem Assistenten für seine Geschäftssoftware. Im November stellte AWS Amazon Q vor, einen KI-gestützten Chatbot für Unternehmen und Entwickler, der Titan-Modelle anbietet, die jedoch nicht so bekannt sind wie Googles Chatbot und Gemini-Modelle.

Bisher hat sich AWS als neutraler Technologieanbieter für KI positioniert und bietet eine breite Palette von KI-Modellen über Bedrock an — von proprietären Anthropic-Modellen bis hin zu Open-Source-Modellen wie Meta Platforms’ neuem Llama 3. Laut Sivasubramanian wird sein Modellbewertungstool, das am Dienstag vollständig verfügbar wurde, die Zeit reduzieren, die Unternehmen für das Testen und Analysieren verschiedener Modelle aufwenden würden.

Fortschritte bei KI-Modellen: Microsofts Phi-3

Drei Monate nachdem Bedrock im September letzten Jahres öffentlich verfügbar wurde, nutzten die meisten AWS-Kunden mehr als ein Modell zur Entwicklung von KI-Anwendungen, wie Amazon berichtet. Microsoft und Google erlauben Kunden ebenfalls, KI-Modelle anderer Unternehmen sowie Open-Source-Modelle von Meta und dem Pariser Startup Mistral AI zu nutzen.

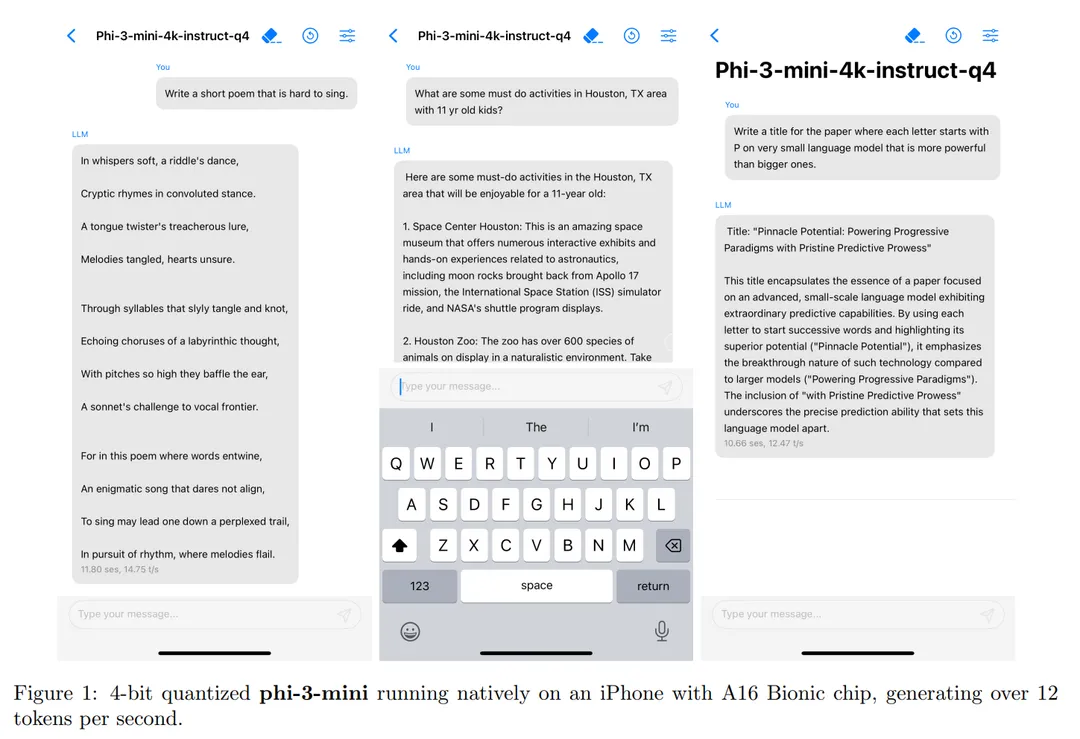

Microsoft kündigte die Veröffentlichung „der funktionalsten und kosteneffektivsten kleinen Sprachmodelle (SLM) an“, die behaupten, dass Phi-3 — die dritte Iteration der Phi-Familie von kleinen Sprachmodellen (SLM) — Modelle vergleichbarer Größe und sogar einige größere übertrifft.

Laut dem Unternehmen gibt es verschiedene Versionen von Phi-3, wobei die kleinste Phi-3 Mini ist, ein Modell mit 3,8 Milliarden Parametern, trainiert auf 3,3 Billionen Tokens. Trotz seiner relativ kleinen Größe — der Llama-3-Korpus wiegt über 15 Billionen Token-Daten — kann Phi-3 Mini immer noch 128 Tausend Kontext-Tokens verarbeiten. Dies macht es vergleichbar mit GPT-4 und übertrifft Llama-3 und Mistral Large in der Token-Kapazität.

Einer der größten Vorteile von Phi-3 Mini ist seine Fähigkeit, auf einem regulären Smartphone zu laufen. Microsoft testete das Modell auf einem iPhone 14, und es lief reibungslos und generierte 14 Tokens pro Sekunde.

Mit anderen Worten, KI-Riesen wie Llama-3 auf Meta.ai und Mistral Large könnten nach einem langen Gespräch oder Hinweis lange vor diesem leichten Modell auf Schwierigkeiten stoßen.

Unternehmen bevorzugen jedoch die Nutzung von KI-Diensten des Cloud-Anbieters, mit dem sie bereits zusammenarbeiten. Laut einigen IT-Direktoren ist generative KI einfacher in Cloud-Plattformen anzuwenden, wo Unternehmensdaten bereits gespeichert sind. Dieser Trend begünstigt AWS, den weltweit größten Cloud-Anbieter, da Unternehmen, wenn sie KI-Dienste nutzen, mehr für die Cloud ausgeben.

Haftungsausschluss: Alle Materialien auf dieser Seite dienen nur zu Informationszwecken. Keines der Materialien sollte als Anlageberatung interpretiert werden. Bitte beachten Sie, dass trotz der Art vieler Materialien, die auf dieser Website erstellt und gehostet werden, HODLFM.DE keine Finanzreferenzressource ist und die Meinungen von Autoren und anderen Mitwirkenden ihre eigenen sind und nicht als finanzielle Beratung aufgefasst werden sollten. Wenn Sie eine solche Beratung benötigen, empfiehlt HODLFM.DE dringend, sich an einen qualifizierten Fachmann der Branche zu wenden.