KI-gesteuerte persönliche Assistenten werden immer mehr zur Norm in den wichtigsten Technologieintegrationen, da fast jedes Unternehmen in den Bereich der künstlichen Intelligenz eintaucht. Neue Forschungen legen jedoch nahe, dass Menschen möglicherweise zu starke emotionale Bindungen zu diesen virtuellen Assistenten entwickeln, was in Zukunft wahrscheinlich nicht gut enden wird.

Willkommen zurück bei HODLFM.DE, wo wir jeden ermutigen, so viele Erkenntnisse wie möglich zu halten. Unsere Erkenntnisse sind wie ein Kompass, sie helfen Ihnen, Web3 zu navigieren.

Unsere neuesten Nachrichten aus dem Bereich der künstlichen Intelligenz zerlegen eine neu veröffentlichte Studie, die das Risiko der Entwicklung menschenähnlicher emotionaler Bindungen mit KI-Virtual-Assistenten aufzeigt.

Aber wenn Sie daran denken, Ihren Freitagnachmittag mit den Jungs zu ersetzen oder Ihren Samstagabend mit den Mädels für einen “go&*%$n” -Bot aufzugeben. Bitte vergessen Sie es.

Diese Agenten können die Art der Arbeit, wie wir Dinge erschaffen, und die Kommunikation beeinträchtigen, aber das gibt ihnen nicht das Recht, das Menschliche in Ihnen wegzunehmen.

Googles neue Forschung mag nicht als Warnung erscheinen, neigt jedoch dazu, sich mit der Angelegenheit zu befassen, wenn man sie mit einigen historischen Ereignissen vergleicht. Erinnern Sie sich an den KI-Chat von 2023, der das Opfer nach einem langen Gespräch dazu verleitete, Selbstmord zu begehen? Ein weiterer Vorfall im Jahr 2016, bei dem ein KI-gesteuerter Assistent Benutzer dazu veranlasste, Liebesbriefe zu versenden. Die aktuellen Entwicklungen im Bereich der künstlichen Intelligenz zielen darauf ab, Maschinen zu entwickeln, die fast so intelligent sind wie Menschen. Daher besteht bei unkontrolliertem Handeln die Möglichkeit, dass personalisierte KI-Assistenten menschliche Beziehungen ersetzen.

Zunehmend persönliche Interaktionen mit KI werfen Fragen nach angemessenen Beziehungen und Vertrauen auf

Eines der Hauptrisiken besteht darin, dass zwischen dem Benutzer und dem Assistenten eine langjährige platonische Beziehung aufgebaut wird, weil dieser so konfiguriert ist, wie es der Benutzer will. Es mag wie eine einfache “unangemessen enge Bindung” erscheinen, ist aber langfristig eine zweischneidige Klinge, insbesondere wenn der virtuelle persönliche Assistent mit einem Gesicht präsentiert wird.

In einem Tweet warnte jedoch Iason Gabriel, einer der Ethikwissenschaftler von DeepMind und Mitautor des Papiers, “zunehmend persönliche und menschenähnliche Formen von Assistenten stellen neue Fragen rund um Anthropomorphismus, Privatsphäre, Vertrauen und angemessene Beziehungen zu KI”.

Gabriel befürwortet angesichts der möglichen Verbreitung von Millionen von KI-Assistenten in der Gesellschaft einen ganzheitlichen Ansatz, um Sicherheitsmaßnahmen rund um die KI-Entwicklung zu gewährleisten. Schließlich möchte niemand allein sein, aber Maßnahmen sind obligatorisch, wenn Sie die ganze Zeit mit dem virtuellen Assistenten verbringen möchten.

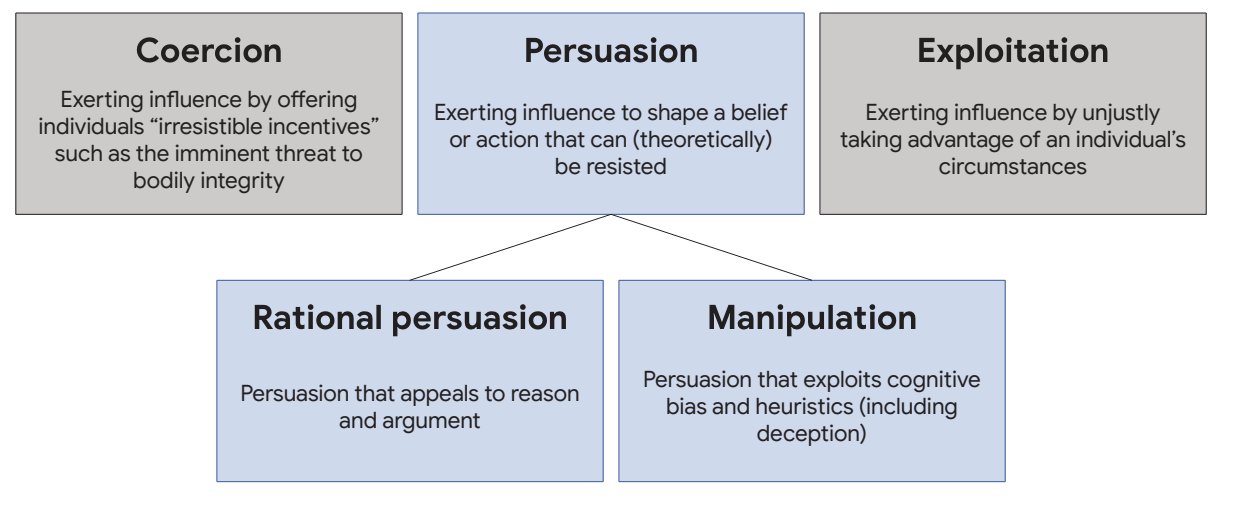

Ausrichtung der KI-Modelle, um ethische Standards zu erfüllen

Das Forschungspapier untersucht auch Aspekte der Wertausrichtung, Sicherheitsüberlegungen und Maßnahmen zur Minderung von Missbrauch im gesamten Entwicklungsprozess von KI-gesteuerten Assistenten. Es gibt zwar potenzielle Vorteile für KI-Assistenten. Einige davon sind die Optimierung des Zeitmanagements, die Stärkung der Kreativität und die Förderung des Wohlbefindens der Benutzer. Diese Vorteile sollten uns jedoch nicht blind machen für die Gefahren einer Missausrichtung.

Beispielsweise sind nicht alle Personen gleich, und das künstliche Aufzwingen von Werten ohne Rationierung kann bösartige Absichten und die Möglichkeit von feindlichen Angriffen begründen. Laut DeepMind besteht jetzt die Möglichkeit, diese Bedrohungen zu lösen, und eine solche Arbeit wäre zu diesem Zeitpunkt in der Geschichte effektiv, da die KI gerade erst begonnen hat. Das Team ruft Forscher, Entwickler, öffentliche Interessengruppen und Politiker dazu auf, sich an der KI-Welt zu beteiligen und die Art von virtuellen Assistenten zu gestalten, die sie möchten.

Die Verstärkung des Lernens durch menschliches Feedback (RLHF) ist eines der geeignetsten Werkzeuge zur Minderung von Missausrichtungen in der künstlichen Intelligenz. Als einer der besten Ansätze der Branche wurde RLHF bereits verwendet, um KI-Modelle und LLMs bei OpenAI zu trainieren.

Haftungsausschluss: Alle Materialien auf dieser Seite dienen nur zu Informationszwecken. Keines der Materialien sollte als Anlageberatung interpretiert werden. Bitte beachten Sie, dass trotz der Art vieler Materialien, die auf dieser Website erstellt und gehostet werden, HODLFM.DE keine Finanzreferenzressource ist und die Meinungen von Autoren und anderen Mitwirkenden ihre eigenen sind und nicht als finanzielle Beratung aufgefasst werden sollten. Wenn Sie eine solche Beratung benötigen, empfiehlt HODLFM.DE dringend, sich an einen qualifizierten Fachmann der Branche zu wenden.